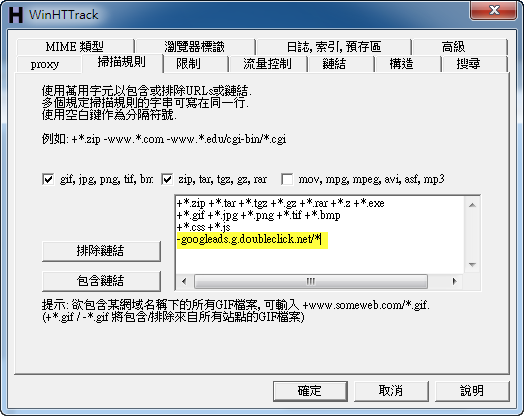

在「掃描規則」裡可以指定要下載哪些類型的檔案,或者是避免下載某些鏈結;像是不希望下載到網頁裡的廣告時,就可以將廣告商的網址排除 ▼

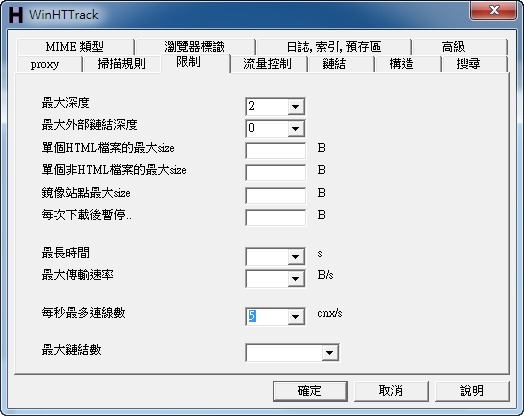

接下來是「限制」項目,這裡比較重要的設定有:

- 「最大深度」,例如 2,表示除了目前專案指定的網址之外,再「深入一層」下載目前網頁裡的鏈結;如果是 3 的話那就是:下載目前指定的網頁(第一層) + 第一層網頁裡的網址(第二層)+ 第二層網頁裡的網址(第三層)… 以此類推。

- 「最大外部鏈結深度」則是設定是否下載外部網站(來自其它網域)的網頁,0 代表不下載。

- 「每秒最多連線數」,設定在一秒之內同時向網站發起多少連線請求。要注意的是,如果設太高的話容易造成伺服器過載,或是被擋 IP ▼

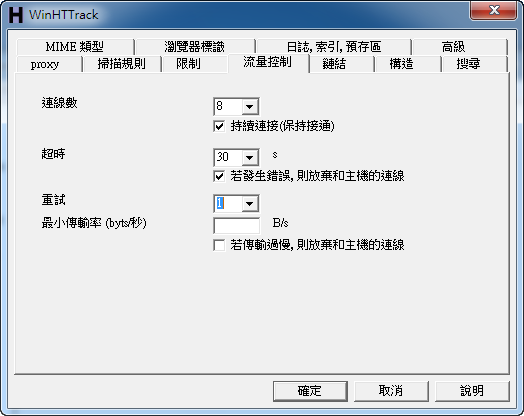

再來是「流量控制」,這裡可以設定:

- 「連線數」,表示下載網站時的連線總數;勾選「持續連接」可以使和網站的連線持續被利用,而不是下載完一個檔案之後斷開再重新連線,提高砍站的效率。

- 「超時」,多久時間網站沒有回應的話就視為超時(timeout)。

- 「重試」,在超時之後重試下載的次數 ▼

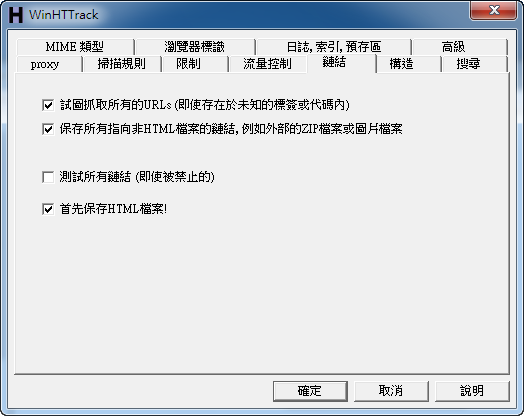

最後是「鏈結」項目,這邊建議勾選「試圖抓取所有的URLs」,在下載網站時試圖解析 JavaScript 中的鏈結;「保存所有指向非HTML檔案的鏈結,例如外部的ZIP檔案或圖片檔案」,讓 HTTrack Website Copier 下載網頁中顯示的圖片或是鏈結的檔案,即使來源是外部網站;以及「首先保存HTML檔案!」,在砍站時先下載 HTML 檔案,讓 HTTrack Website Copier 提早分析網頁中的鏈結,以提高砍站的整體速度 ▼

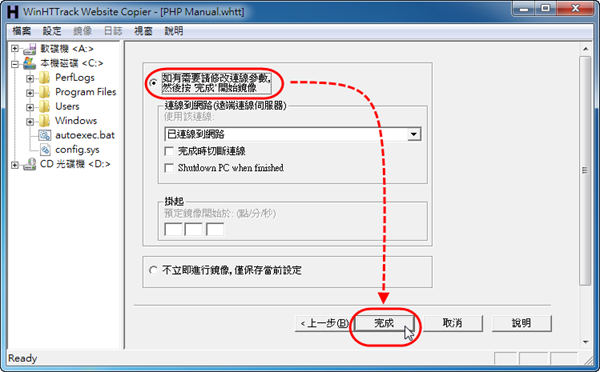

當設定好專案之後,按下「確定」關閉選項視窗,再按「下一步」來到建立專案的最後一個步驟。這裡 HTTrack Website Copier 會預設選擇「如果需要請修改連線參數,然後按完成開始鏡像」,意思就是按下「完成」後就會開始下載網站(砍站)了 ▼

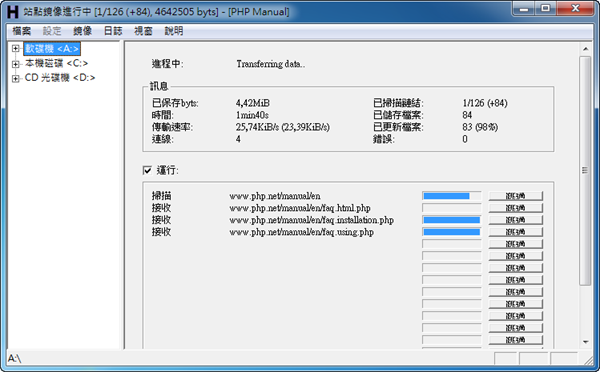

網站下載(砍站)中… ▼

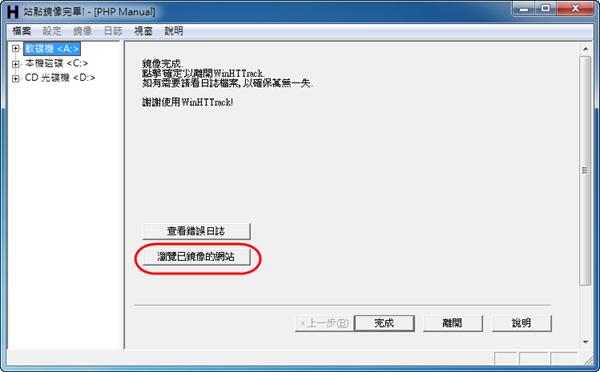

網站下載完畢後可以按下「瀏覽已鏡像的網站」來開始進行離線瀏覽 ▼

Pages: 1 2

其它像是備份網站、製作鏡像或是「資料探勘」等也都能派得上用場。

請問「資料探勘」要怎麼做?我怎麼不知道這一套有「Data Mining」的功能

我的意思是指,可以先利用 HTTrack 把網路上的資料下載回來後,再用專門的分析程式進行 Data Mining。

如果網站下載完畢後,網站更新了,要怎麼辦?

再『砍』一次。

下載用了,覺得很好用,謝謝您介紹這個軟體!

假如遇到網站需要”登入”的可以砍嗎? 3Q

可以把google砍下來帶著用嗎?XXXXD